Seit wann gibt es die Digitalisierung? Teil I

Digitalisierung / Industrie 4.0Eine Reise in die Geschichte des Computers und der Digitalisierung

Wann begann die Digitalisierung? Eine Frage, die nicht so einfach zu klären ist. Der Begriff „Industrie 4.0“ – der in Deutschland oft synonym gebraucht wird – taucht erst ab 2011 auf. Auf der Suche nach dem Ursprung der Digitalisierung müssen wir aber viel früher starten. Der erste Teil unseres zweiteiligen Artikels „Die Geschichte der Digitalisierung“.

Historikerinnen und Historiker beginnen ihre Analysen gerne mit dem Auseinandernehmen und Erforschen von Begriffen. Bei dem Wort „digital“ ist der Wortstamm das Lateinische „digitus“, das „Finger, Zehe“ meint und im Weiteren auf das Abzählen von Zahlen unter 10 an den Fingern anspielt. Im Englischen steht das Wort „digit“ neben „Zahl“ auch für „Finger“. Die Hand hat zehn Finger – und Zehn als Zahl dargestellt besteht aus 1 und 0, zugleich auch die beiden Grundzustände eines Computers im Binärsystem, Strom aus und Strom an.

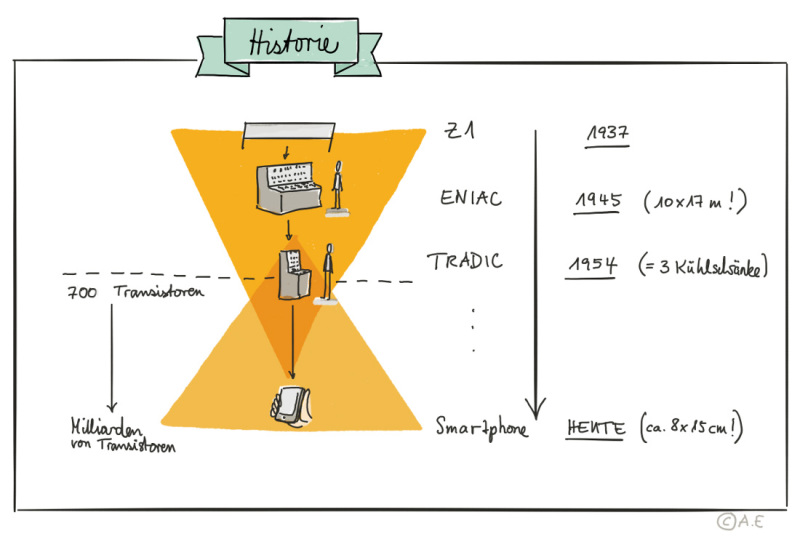

Die breite Verwendung des Begriffs „digital“ im heutigen Sinne ist bedeutend jünger. Sie kommt auf mit den ersten Computern, die digital rechneten, also mit dem Binärsystem 1 und 0. Diese entstanden in den späten 1930er/frühen 1940er Jahren. So entwickelte 1937 der deutsche Ingenieur Konrad Zuse den Z1. Dieser war selbst noch mechanisch gebaut und ähnelte mehr Rechenschiebern oder Rechenmaschinen, die es bereits seit Jahrhunderten gab. Das Besondere an ihm: Er konnte als erster mit den binären Zahlen rechnen und war gleichzeitig frei programmierbar.

Kurze Zeit später entstanden Computer, die schon eher unseren heutigen PCs ähneln, wie der amerikanische ENIAC 1944 und der deutsche Zuse Z4 1945. Beide rechneten elektronisch, wenn auch mit Elektronenröhren und Relais, statt den heute verwendeten Transistoren. Eine Ähnlichkeit, die sich aber nur auf die inneren Werte bezog: Schließlich nahm ENIAC eine Halle von 10 mal 17 Metern ein! 1954 entstand der amerikanische TRADIC, der Transistoren statt Elektronenröhren zur Berechnung verwendete – und nur noch so groß wie drei Kühlschränke war. TRADIC steht für TRansistorized Airborne DIgital Computer – wo wir unseren Begriff „digital“ wiederfinden.

Null und Eins – das Geheimnis der Digitalisierung

Aber warum war es für die Geschichte des Computers so wichtig binär zu rechnen? Binäre Zahlen haben nur zwei eindeutige Zustände, entweder 0 und 1. Das macht die Unterscheidung auf Hardware-Ebene – also in einer Elektronenröhre, einem Transistor oder Rechenschieber – einfacher als eine Vielzahl von Zuständen. Die beiden Zustände 0 und 1 sie lassen sich elektrisch mit „Strom an“ und „Strom aus“ darstellen, statt mit verschiedenen Spannungszuständen (z. B. 1 Volt = Ziffer 1, 2 Volt = Ziffer 2), was komplexe Schaltungen erfordern würde. Das macht sie zugleich auch fehlersicherer bei Kopie und Speicherung. Außerdem kann jede Art von Informationsmuster einfach in Binärcode gespeichert werden, was sie universell einsetzbar macht. All das definierte der Mathematiker Claude Shannon bereits 1948 in dem Aufsatz “A Mathematical Theory of Communication“ (PDF).

Bipolar-Transistoren, die kleinsten Bau- und Rechenelemente eines modernen Computers, können genau zwei Dinge: Strom durchlassen oder nicht durchlassen – sie sind eben „an“ und „aus“, Zustände, die im Binärsystem „0“ und „1“ entsprechen. So lässt sich mit „Strom an“ und „Strom aus“ rechnen. Und weil man Transistoren sehr gut sehr klein bauen kann, eignen sie sich so gut, um aus ihnen leistungsfähige Computer herzustellen. Zum Größenvergleich: Die kleinsten Transistoren sind circa 20 bis 30 Nanometer groß – etwa 250-mal kleiner als ein rotes Blutkörperchen. Computerchips bringen heute Milliarden von Transistoren auf der Größe eines Fingernagels unter und können dank dieser Miniaturisierung so schnell rechnen.

Somit begann in den 1950er Jahren der unaufhörliche Siegeszug des Digitalcomputers. Seit dieser Zeit verdoppelt sich die Geschwindigkeit eines Computers alle zwei Jahre – das berühmte Moore’s Law – und wir sehen in unserem Alltag immer mehr computerisierte Anwendungen. Spätestens mit dem Beginn des Internets nahm zudem der Datenaustausch und -Speicherung enorm zu.

Übrigens: Auch viele weitere Digitaltechnologien, die heute state-of-the-art sind, haben weit zurückreichende Ursprünge. Die künstliche Intelligenz, heute in aller Munde als das nächste große Ding, findet in den frühen 1960ern ihren Anfang. Auch aufgrund der Tatsache, dass Rechner damals noch nicht potent genug waren, wurde die KI jedoch lange Zeit stiefmütterlich von Wissenschaft und Wirtschaft behandelt.

Einen Moment bitte – das klingt alles gar nicht nach der Digitalisierung, die so in den Medien präsent ist!

Das ist richtig. Was wir heute unter Digitalisierung verstehen – Smartphones, Cloud, KI und co – hat wenig mit Konrad Zuse und kühlschrankgroßen Computern gemein. Dies sind aber ohne Frage die Ursprünge der Digitalisierung. Und sie sind ein wichtiger Baustein auf dem Weg zur Beantwortung unserer Ausgangsfrage: Wann begann die Digitalisierung?

Dazu sollten wir zunächst einmal klären, was mit dem Begriff Digitalisierung denn überhaupt gemeint ist. Nur damit wir eine gemeinsame Sprache sprechen. Wir verstehen heute darunter einen gesellschaftlichen Prozess, der den massiven Einsatz von Digitaltechnologien in unserem Alltag beschreibt und der zu einem Wandel der Funktionsweise von Gesellschaft, Arbeit und Wirtschaft beiträgt. All das war in den 50ern noch nicht der Fall, wo die „elektronische Revolution“ eher in den E-Gitarren des Rock’n’Roll erklang.

Um der Digitalisierung richtig zu verstehen und ihr letztendlich auf die Schliche zu kommen, müssen wir uns noch einen zweiten Prozess ansehen, der untrennbar mit der Digitalisierung verbunden ist und den wir eigentlich meinen, wenn wir davon sprechen: die digitalisierte Automatisierung.

Erfolgsgeschichten

Von der Elbe an die Weser: Wie LITE Games in Bremen neue Spiele-Horizonte erobert

Das Unternehmen LITE Games bringt Klassiker wie Rommé als moderne Mobile Games zurück – mit frischem Design und smarten Features. Geschäftsführer Michael Becker setzt dabei auf zukunftsweisende Technologien und die kreative Kraft Bremens. Bei der Ansiedlung in der Bremer Überseestadt unterstützte die WFB.

Mehr erfahrenKI in der praktischen Anwendung – ein Blick in die Bremer Branchen

Künstliche Intelligenz (KI) dringt ein in unsere Autos, Zahnbürsten, Produktionsanlagen und Büros. Wo ist sie schon Unternehmensalltag? Beispiele für KI in der Anwendung.

Mehr erfahrenSchlaues Tool hilft Rathäusern und Ratsuchenden - Bremerhavener Start-up treibt Digitalisierung in Behörden mit KI voran

Die Arbeit von Behörden wird immer komplexer; parallel wächst der Informationsbedarf in der Bevölkerung. Zwei Studierende der Hochschule Bremerhaven treten diesem Dilemma mithilfe von KI entgegen.

zur BiS Bremerhaven